Le 9 avril 2025, l’

AWS Summit Paris a rassemblé plusieurs milliers de professionnels au

Palais des Congrès pour une journée

(intense) d’exploration des dernières

innovations cloud et

IA d’

Amazon Web Services.

👉 Nos consultants Kevin, Dunan, Alassane et Mickael étaient présents sur place, aux côtés de nos co-directeurs de MARGO AI Solutions, Hugo et Ludovic pour décrypter les tendances, tester les nouveaux services et échanger directement avec les experts AWS et leurs partenaires.

Cette édition marque une étape claire : on ne parle plus d’expérimentation IA, mais d’industrialisation raisonnée, avec des cas d’usage en production, des briques techniques solides, et une forte prise de conscience sur les enjeux de souveraineté et de sécurité.

Voici leur synthèse croisée de cette journée intense – un concentré d’enseignements concrets pour tous les acteurs Data & IT.

🔥IA Générative : de l’expérimentation à l’industrialisation

Sans surprise, l’IA Générative (GenAI) a dominé les discussions. Mais là où 2024 laissait encore place à l’exploration, 2025 marque un tournant : celui du passage à l’échelle.

✅ Des cas d’usage en production, portés par des acteurs de référence

L’édition 2025 a été marquée par de nombreux témoignages clients. Parmi les plus marquants :

- PayFit a présenté son premier assistant RH GenAI avec Amazon Bedrock, en mobilisant les FMs (Foundation Models) d’Anthropic et Cohere. L’objectif : automatiser les réponses aux clients de la plateforme Payfit.

- Safran utilise un RAG (Retrieval-Augmented Generation) pour interroger des rapports de pannes d’équipements industriels, réduisant drastiquement le temps de diagnostic. Une approche applicable aux métiers d’ingénierie, à la maintenance ou à la conformité réglementaire.

- Owkin mobilise la GenAI pour ses recherches biomédicales.

- Qonto l’intègre dans ses processus de détection de fraude et d’automatisation documentaire.

- Poolside a montré des usages de GenAI dans l’ingénierie avancée.

“Ce ne sont plus des prototypes. Ce sont des modèles IA en production, utilisés par des leaders de l’industrie, de la santé ou de la finance.”

Consultant MARGO

💡 À retenir : l’IA ne se limite plus à l’assistance. Elle devient moteur de nouveaux produits et services. Amazon encourage cette dynamique avec ses propres modèles fondamentaux, comme Amazon Nova, et des services pensés pour la productivité (Amazon Q, Partner Assistant…).

📊 Tendances clés du marché IA en Europe :

- +11 % de croissance de l’adoption de l’IA Générative en Europe entre 2024 et 2025

- 42 % de taux d’adoption global de l’IA Générative (toutes zones confondues)

- La France reste en retrait, malgré son potentiel, freinée par des incertitudes réglementaires et un déficit de compétences

Ces chiffres, présentés en keynote, illustrent une dynamique forte mais encore contrastée selon les pays. L’enjeu pour les entreprises françaises : transformer l’expérimentation en valeur concrète, rapidement.

🔁 De l’IA “assistante” à l’IA “créatrice”

AWS introduit un modèle de maturité en trois phases :

1. Enhancement : améliorer les processus existants

2. Acceleration : automatiser à grande échelle

3. Creation : générer de nouveaux services, produits ou modèles économiques

“Chez les clients que j’accompagne, on sent une vraie bascule vers l’étape ‘accélération’. La GenAI n’est plus cantonnée aux labs.”

Hugo Prignol, co-directeur AI Solutions

💡 À retenir : l’IA ne se limite plus à l’assistance. Elle devient moteur de nouveaux produits et services. Amazon encourage cette dynamique avec ses propres modèles fondamentaux, comme Amazon Nova, et des services pensés pour la productivité (Amazon Q, Partner Assistant…).

🧰 Une IA “engineered for velocity”

L’écosystème AWS est pensé pour accélérer le time-to-value :

- Amazon Bedrock pour intégrer des modèles pré-entraînés

- Amazon Q Business pour copiloter la documentation et les process internes

- Amazon SageMaker pour entraîner ou affiner ses propres modèles

- S3 Intelligent Tiering pour automatiser la gestion des données sans intervention humaine

La clé ? La capacité à industrialiser vite et bien, sans sacrifier la sécurité ni la gouvernance.

Vous souhaitez en savoir plus ? Découvrez les insights de l’AWS GEN AI DAY : FlexAI, Hugging Face, AWS.

🧠 GraphRAG et structuration des connaissances : la nouvelle frontière de la GenAI

La session “GraphRAG: augmenter de 35% la qualité des réponses de votre chatbot” a particulièrement marqué les esprits. L’approche consiste à enrichir le RAG classique par une structuration sémantique des connaissances. Résultat : une amélioration significative de la pertinence des réponses, notamment dans les domaines complexes (juridique, médical, assurance…).

🔎 Technologies mises en avant :

- Amazon Bedrock : intégration fluide de modèles comme Claude (Anthropic), Llama (Meta), Mistral, ou Titan (AWS)

- S3 Intelligent Tiering : stockage intelligent optimisé par IA

- Amazon Neptune + GraphRAG : structuration des connaissances sous forme de graphe pour des réponses IA plus pertinentes

- Apache Iceberg : format de table performant pour les pipelines analytiques

“GraphRAG a vraiment retenu mon attention. C’est une méthode qui structure l’intelligence avant de générer une réponse, elle permet une meilleure contextualisation des réponses dans des environnements métiers riches en règles. C’est idéal pour les secteurs complexes comme l’assurance ou la finance réglementée.”

Consultant MARGO

🔐 Sécurité des chaînes IA : la priorité absolue en 2025

Alors que 3 entreprises sur 10 disent vouloir avancer sur la GenAI mais ne pas en avoir les moyens, AWS a réaffirmé sa priorité : faire de la sécurité un levier d’adoption.

“Les entreprises n’ont pas peur de l’IA. Elles ont peur de mal la sécuriser.”

Ludovic, co-directeur MARGO AI Solutions

🛡️ Une approche “Secure-by-Design” à tous les niveaux

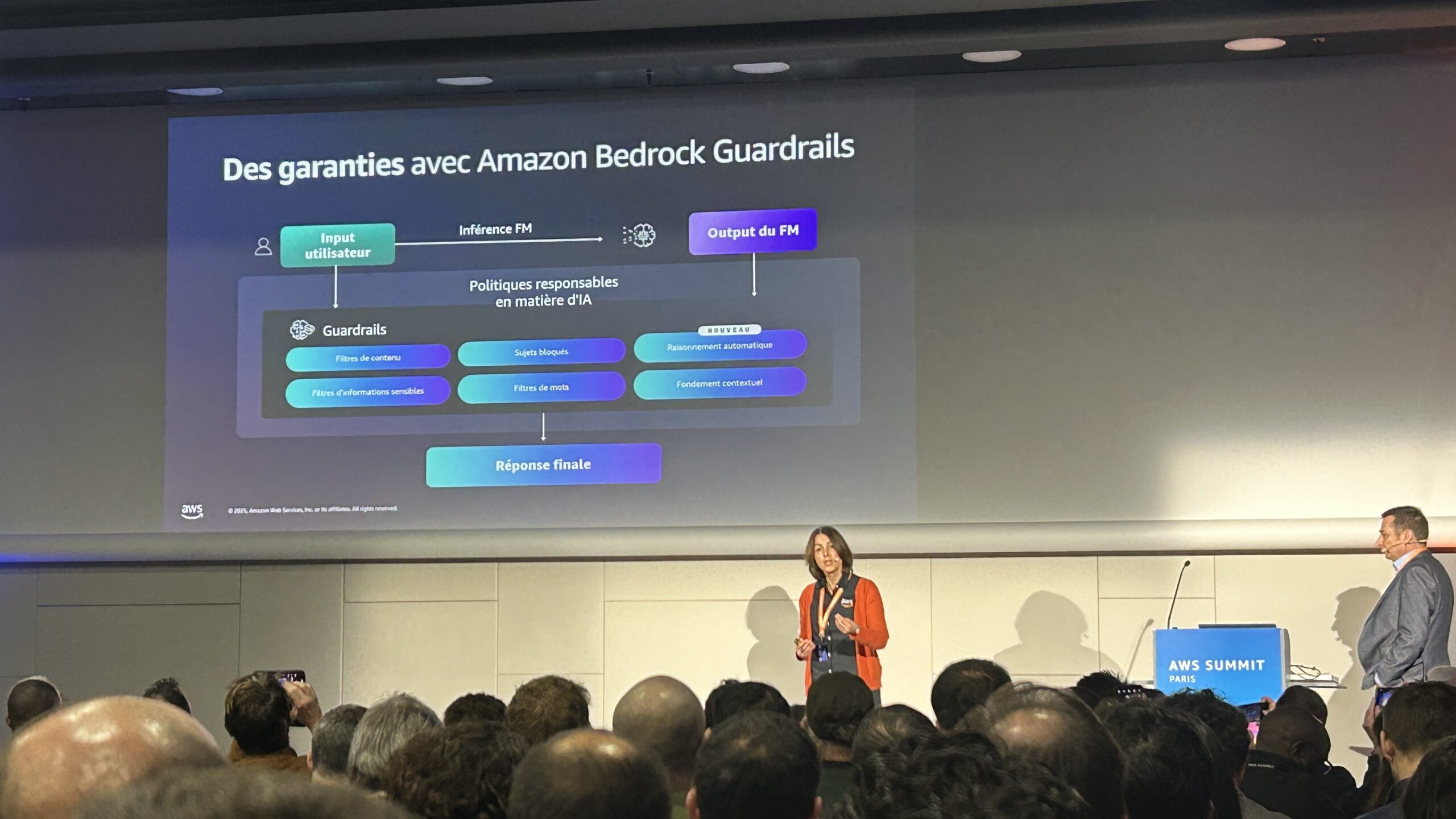

Lors d’une session dédiée à la souveraineté et à la cybersécurité du cloud, AWS a rappelé les fondamentaux à mettre en œuvre pour sécuriser toute la chaîne de traitement de l’IA – de la donnée brute aux réponses générées :

- Secure-by-Design : intégration native de la sécurité dans les workflows IA

- Chiffrement bout-en-bout via AWS KMS et Amazon Macie

- Gestion fine des accès IAM, y compris pour les agents IA

- Auditabilité et journalisation des outputs générés par les LLMs

Des interventions notables ont été assurées par Tony Baudot, Baptiste Cazagou et Charles Grenet, chacun insistant sur la nécessité de construire une gouvernance solide, alignée avec les exigences européennes.

📊Gouvernance & souveraineté : au-delà de la localisation des données

AWS a clarifié un point souvent flou : la souveraineté cloud ne se limite pas à “où” sont stockées les données, mais qui peut y accéder, sous quelles conditions et avec quels contrôles.

C’est une vision alignée avec les cadres RGPD et DORA, qui imposent une responsabilité opérationnelle aux entreprises dans la gestion de leurs systèmes IA.

💬 À noter : AWS met en avant les bonnes pratiques issues de la communauté OWASP AI Security & Privacy Guide pour encadrer les risques liés aux LLMs (Large Language Models), notamment en ce qui concerne :

- Les attaques par prompt injection

- La mémorisation involontaire de données sensibles

- Le manque de traçabilité des réponses IA

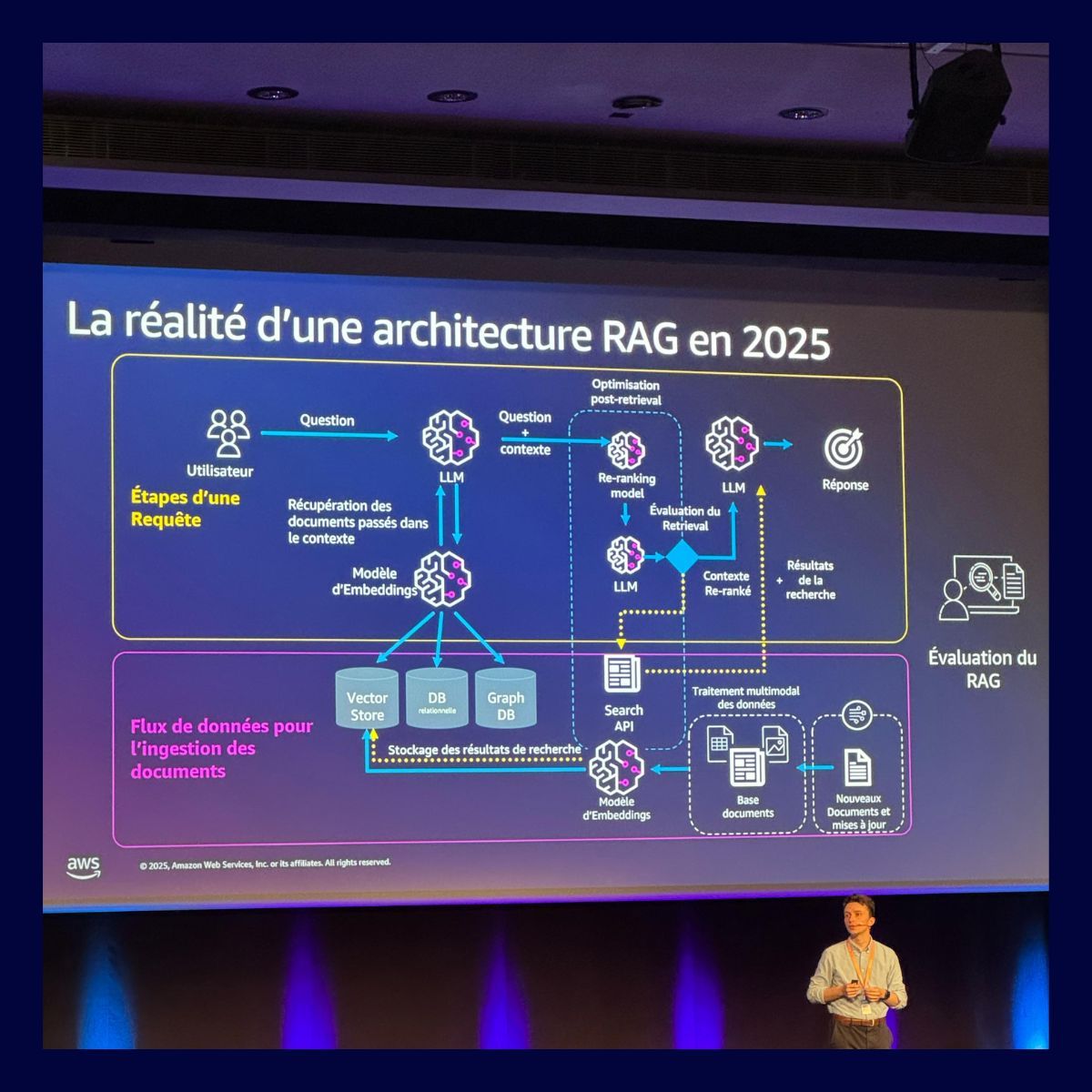

🔍 RAG Avancé : Trois leviers pour optimiser vos applications IA

Le RAG (Retrieval-Augmented Generation) est aujourd’hui un pilier des systèmes d’IA générative en entreprise. Il permet de combiner la puissance des grands modèles de langage avec des bases documentaires spécifiques pour produire des réponses contextualisées.

Mais si vous pensez que le RAG se limite à de la simple recherche vectorielle suivie d’une génération, détrompez-vous. Il existe un RAG “avancé”, beaucoup plus puissant — à condition d’optimiser chaque étape de la chaîne.

Voici les trois leviers essentiels à activer pour améliorer la performance de vos systèmes RAG.

1

Ingestion des données : maîtriser la segmentation

La première étape critique du pipeline RAG, c’est l’ingestion des données. Et dans cette phase, tout se joue au moment du chunking, c’est-à-dire la découpe des documents en blocs exploitables.

Une mauvaise segmentation peut casser le sens d’un paragraphe ou isoler des phrases de leur contexte, ce qui dégrade considérablement la qualité des réponses du LLM.

Pour éviter cela, voici quelques techniques à explorer :

- Segmentation de texte récursive : découpe intelligente en respectant la structure (titres, sous-titres, paragraphes).

- Segmentation hiérarchique : priorisation de l’information en fonction du niveau de granularité.

- Segmentation sémantique : découpe basée sur le sens, pour préserver la cohérence des idées.

Ces approches permettent de mieux contextualiser l’information pour les étapes suivantes.

2

Récupération des données : enrichir la logique de recherche

La majorité des systèmes RAG reposent uniquement sur la similarité vectorielle pour retrouver les chunks pertinents. Mais ce n’est souvent pas suffisant.

Une amélioration consiste à introduire une logique de similarité graphique : en créant des liens sémantiques ou structurels entre les documents (via graphes de connaissance ou métadonnées), vous permettez au système de récupérer des éléments connexes mais non similaires, qui enrichissent considérablement le contexte de réponse.

Résultat :

Un LLM qui comprend mieux les nuances entre documents, même quand ceux-ci abordent des sujets différents mais liés.

3

Post-processing : filtrer pour mieux guider le LLM

La dernière étape, souvent sous-estimée, consiste à filtrer intelligemment les résultats récupérés avant de les envoyer au modèle.

Il ne s’agit pas seulement de restituer tous les chunks “pertinents”, mais d’en sélectionner ceux qui répondent précisément au besoin de l’utilisateur.

Cela peut passer par :

- Des filtres documentaires (types de sources, auteur, fiabilité).

- Des filtres temporels (restreindre à une plage de dates).

- Des filtres métiers ou contextuels (en fonction du rôle, du secteur, etc.).

Une bonne stratégie de post-traitement réduit le bruit, minimise les hallucinations et augmente la pertinence des réponses.

🧠 Le RAG avancé : une chaîne optimisée de bout en bout

Le RAG avancé ne se contente pas de relier un moteur de recherche à un LLM. Il repose sur une conception fine et maîtrisée de chaque étape, du prétraitement à la génération finale.

C’est cette rigueur qui permet de transformer une simple application d’IA en un véritable copilote métier, capable de raisonner sur des données complexes, contextualisées, et en constante évolution.

💬 Et vous, où en êtes-vous dans votre stratégie RAG ?

Avez-vous mis en place des mécanismes d’optimisation à ces trois niveaux ?

Si vous souhaitez en discuter ou benchmarker votre approche, je serais ravi d’échanger.

🧭 AWS vs GCP / Azure : une bataille sur l’écosystème, pas sur les modèles

“En matière de modèles de GenAI, GCP a une avance claire. Mais sur les outils d’intégration et la scalabilité, AWS reste le leader incontesté.”

Consultant MARGO

AWS ne mise pas uniquement sur la performance des modèles, mais sur la robustesse de son écosystème : intégration fluide, sécurité, monitoring, optimisation des coûts… tout y est.

La stratégie : faire de Bedrock + Q + S3 + IAM une base industrialisable, au-delà du simple PoC.

💡 Quels enseignements pour votre entreprise ?

Pour les grandes entreprises et les acteurs du secteur financier ou assurantiel, les insights partagés lors de ce Summit offrent trois leviers de réflexion immédiats :

1.Industrialiser sans complexifier : La GenAI peut s’industrialiser à moindre coût et à grande échelle, à condition d’avoir la bonne architecture (Bedrock, RAG, S3, SageMaker…).

2.Intégrer la sécurité dans le design IA : Ne plus opposer innovation et conformité. L’approche “Secure-by-Design” est clé.

3.Faire le tri dans l’offre AWS : L’écosystème est vaste, mais chaque brique peut répondre à un besoin spécifique métier ou technique. Mieux vaut être accompagné pour choisir.

En conclusion : AWS muscle son jeu… et appelle les entreprises à accélérer

L’AWS Summit 2025 confirme une chose : l’intelligence artificielle entre dans une phase de structuration industrielle. Les outils sont là, les cas d’usage se multiplient, et les entreprises prêtes à franchir le pas seront les premières à tirer profit de cette nouvelle donne.

Et pour vous, quelle est la prochaine étape ?

Chez MARGO, nous aidons les directions IT, Data et Métier à :

- Identifier les cas d’usage IA les plus pertinents

- Sélectionner et intégrer les briques AWS adaptées

- Monter en compétence via des formations ciblées

- Industrialiser des solutions d’IA responsables, sécurisées et scalables

👉 Envie d’échanger sur vos projets IA et Cloud ? Contactez-nous pour une session de cadrage gratuite avec nos experts.

FAQ : Ce que vous devez retenir de l’AWS Summit 2025

Q1 : Quelles sont les annonces majeures de l’AWS Summit Paris 2025 ?

L’annonce majeure concerne la disponibilité de Pixtral Large (Mistral AI) sur Amazon Bedrock, les nouveaux services IA comme Amazon Q Business et un accent fort sur la sécurité des chaînes IA.

Q2 : Quelles sont les technologies AWS les plus utilisées pour l’IA Générative ?

Les plus utilisées sont Amazon Bedrock (modèles FMs), SageMaker Studio (MLOps), GraphRAG avec Neptune, S3 Intelligent Tiering et Apache Iceberg pour le traitement analytique.

Q3 : Quels cas d’usage IA concrets ont été présentés ?

PayFit (assistant RH IA), Safran (diagnostic via RAG), Qonto (fraude & documents), Owkin (santé) et Poolside (ingénierie IA).

Q4 : Quelles sont les priorités sécurité évoquées par AWS ?

Chiffrement, IAM granulaire, auditabilité LLMs, conformité RGPD/DORA, et standards OWASP AI Security & Privacy Guide.